Approche data driven : collecter, constater, décider

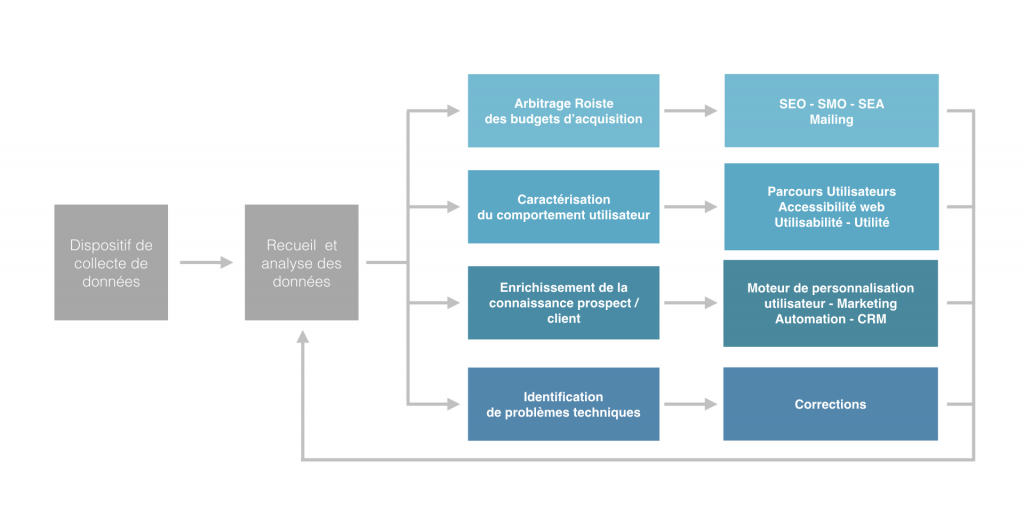

L’approche data-driven a pour objectif de faciliter les prises de décisions stratégiques pour les entreprises en les éclairant des données des utilisateurs.

Elle se nourrit des données produites par :

- les interactions entre un utilisateur et une marque,

- les évaluations des écarts entre des normes et un dispositif de marque (site internet, application mobile, etc).

Ces données peuvent être de différents types (structurées et non structurées) et collectées par toutes sortes de moyens, de l’interview libre (questions ouvertes – données non structurées) aux outils informatiques enregistrant automatiquement les données des utilisateurs (modèle structuré).

Cette approche sert 4 enjeux majeurs pour l’entreprise

- le pilotage des tactiques d’acquisition : par l’identification des sources de génération d’audience les plus rentables (rapport du coût d’achat de l’audience sur le nombre de contacts ou d’acheteurs).

- la conduite de l’optimisation de l’expérience utilisateur : par la caractérisation du comportement utilisateur (calcul et visualisation des taux de passage et d’abandon à chaque étape d’un tunnel d’achat ou de création de compte).

- la gestion de l’augmentation de la connaissance client : qualification de l’utilisateur et de son comportement.

La qualification de l’utilisateur : quel est le cycle de vie de l’utilisateur ?

Un utilisateur lors de son interaction avec une marque aura possiblement 4 statuts successifs acquis par des actions précises et/ou des scores (système de notation) définis par des points attribués à certaines actions et cumulés.- Anonyme, visiteur : c’est sa première visite ou le visiteur ne s’est jamais engagé vis à vis de la marque,

- Prospect ou candidat : c’est un visiteur récurent qui témoigne d’un intérêt réel pour les produits ou services de la marque (MQL : Marketing Qualified Lead),

- Contact : c’est un prospect activable, un utilisateur qui a fourni un point de contact (SQL : Sales Qualified lead),

- Client ou collaborateur : selon la nature de sa relation avec l’entreprise ou la marque.

- le pilotage des versions correctives et évolutives de l’applicatif : par l’identification d’anomalies techniques (non respect des normes, de la compatibilité avec les mises à jour).

L’approche data-driven décrit un processus cyclique et itératif caractérisé par :

- la collecte des données,

- l’exploitation, la préparation et l’analyse des données,

- la prise de décision, les corrections et les optimisations des dispositifs.

Les deux premiers points sont détaillés ci-après; la prise de décision fera l’objet d’articles dédiés ultérieurement.

Collecte de données

Les types de données

Les données déclaratives

Les données déclaratives sont obtenues suite au renseignement d’informations par l’utilisateur sur des formulaires ou lors de sa participation à une interview. Selon le mode retenu, les données seront plus ou moins structurées et il sera nécessaire d’avoir une phase de préparation plus ou moins importante pour pouvoir les exploiter et les interpréter.

Les données d’interaction

Les données d’interaction sont généralement des données permettant d’augmenter la connaissance d’un utilisateur. Ces données résultent de traitements asynchrones sur les données relatives à la navigation de l’utilisateur (temps de consultation de rubriques, RFM : Récence Fréquence Montant) de sorte à révéler une appétence pour une thématique ou au contraire détecter un risque d’attrition.

Appétence et risque d’attrition

1 / Exemple de cas d’usage : Retail – Appétence

Sur un support de distribution de matériel photographique, la consultation de certains produits induit que l’utilisateur est plus orienté vers un équipement professionnel qu’amateur (même éclairé). La qualification de l’appétence permet de proposer a posteriori lors d’un prochain point de contact (visite suivante / relance par mail ) des produits plus en adéquation avec le niveau de maturité et l’intérêt de l’utilisateur.

2 / Exemple de cas d’usage : Assurances – banque finance & Risque d’attrition

Un utilisateur détenant un produit d’assurance vie avec un capital de 60 K€ qui réalise des simulations d’assurances habitation et/ou automobile pour un bien dont les caractéristiques ne sont pas cohérentes avec les contrats de ses biens détenus sera susceptible de réaliser un désinvestissement pour acquérir un nouveau bien.

Un traitement de ces données permettra à la compagnie de proposer une offre de financement adaptée pour prévenir d’un potentiel désinvestissement.

Les données de conformité

Ces données résultent d’une comparaison entre une norme et un dispositif, ces métriques permettent d’évaluer l’effort à fournir pour que le dispositif réponde à la norme.

Exemple : évaluer le reste à faire lors d’une optimisation d’un site internet pour les moteurs de recherche (SEO Onsite).

Les collectes

Les collectes orientées vers l’utilisateur

- les solutions de digital analytics

Basées sur des composants additionnels en javaScript (exécutés par le navigateur) pour les sites web, ces solutions permettent d’analyser l’audience, l’acquisition, les parcours utilisateurs et la compatibilité des supports digitaux avec les standards du marché. Dans les solutions majeures, on recense Google Analytics, Adobe Analytics, Content Square, At Internet, etc. Ces solutions sont pour certaines labellisées OJD (Office de justification des diffusions des supports de publicité) – Organisme tiers de certification d’audience, - les applicatifs (CMS, PIM, CXM, XRM, CRM) qui embarquent des solutions analytics ad hoc, souvent exécutés par le serveur lors de l’appel d’un asset digital (page, image, video, etc),

- les analyseurs de logs serveur (GOAccess, webalizer),

- les solutions analytics fournies par les CDN (CloudFlare, Akamai, Cloudfront S3stat),

- les enquêtes, sondages, formulaires web ou papier, interviews, questionnaires d’évaluation,

- les DMP, les solutions de marketing automation,

- les analyseurs sémantiques, les écoutes de conversation,

- les plateformes de gestion de publicités (ex : Google, Linkedin, Facebook Ads),

- etc.

Les collectes orientées vers le dispositif

- les outils d’audits automatisés (OnCrawl, SiteDoctor, Woorank, Screaming Frog, GTMETRIX, Load impact, etc),

- les analyseurs de logs serveur (Python + Google DataStudio, OnCrawl logs analyzer),

- les outils de test de charge,

- les sondes serveurs en mesure d’évaluer la disponibilité de ces derniers,

- les outils de scrapping utilisés notamment pour enrichir un jeu de données avec des données de documents externes.

Préparation et exploitation des données

L’exploitation des données nécessite deux étapes préalables, la validation de leur qualité et leur préparation. La qualité des données est définie par la conformité des données pour un usage prévu.

La qualité des données se vérifie par l’évaluation de 6 critères

- pertinence : les données sont adaptées à l’objet qu’elles décrivent / enrichissent,

- cohérence : la lecture de ces données renvoie toujours leur dernière écriture effectuée,

- exactitude : les données doivent être exactes, complètes et mises à jour,

- complétude : qualité de ce qui est complet. Relatif à l’exhaustivité des données,

- unicité : caractère de celui qui est unique, absence de doublon,

- consistance : état de stabilité, solidité, désigne l’état des données qui, lors de leur traitement, de leur conservation ou de leur transmission, ne subissent aucune altération ou destruction volontaire ou accidentelle.

Des outils comme le projet Open Refine (Google) peuvent assister les utilisateurs pour ces étapes. On pourra également utiliser Python et PANDA via un Notebooks Azure pour définir un premier niveau de rapport de qualité de la donnée (nombre de valeurs présentes, manquantes, uniques, cohérentes avec le type de donnée attendue, etc.).

La phase de préparation consistera à sélectionner, transformer les données brutes en informations utiles. On y pratiquera des agrégations de plusieurs sources de données, des transformations de formats, des calculs de nouvelles valeurs, etc.

Observation et analyse des données

Les utilisateurs et la visualisation de données

- “Le poids des mots, le choc des photos” (slogan de Paris Match). La stimulation visuelle attire notre attention, et déclenche des émotions,

- “L’image est devenue le principal rapport de l’individu au monde qu’auparavant il regardait par lui-même” (Guy Debord),

- “Image, image, quand tu nous tiens…, semble crier cette fin de siècle, habitée et envahie par l’image. Cette image fixe puis animée dont se méfie la culture occidentale depuis les Grecs, a définitivement triomphé.” (Dominique Wolton -Directeur de recherche au CNRS – https://www.cairn.info/load_pdf.php?ID_ARTICLE=HERM_013_0009),

- “Un bon croquis vaut mieux qu’un long discours” (Napoléon Bonaparte),

- “L’influence positive des images sur la compréhension d’un message et généralement acceptée et établie” (Science Po Learning lab ).

De ces considérations, il paraît évident que l’accès à la donnée, pour atteindre le plus grand nombre d’individus, ne pourra s’effectuer que par la transformation de la matière brute en représentation graphique.

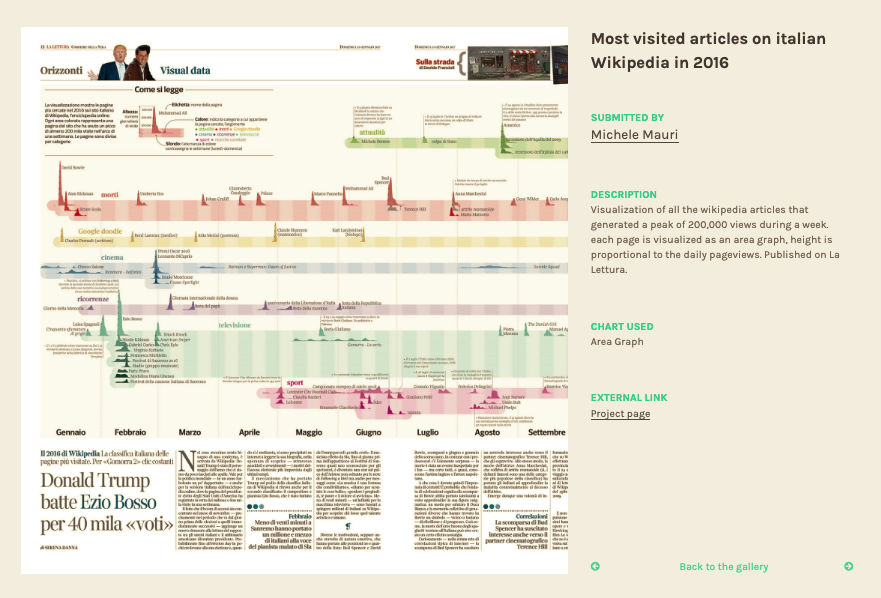

La data vizualisation

Nous listons ci-après des outils variés vous permettant de représenter graphiquement des jeux de données.

Les kits graphiques permettant de générer des images

- rawgraphs.io,

- https://app.datawrapper.de.

Exemple RawGraphs

Les services distribués

Qlick, Toucantoco, Tableau ou encore Google Data Studio.

Les librairies orientées data vizualisation en JavaScript, R ou Python

- JavaScript : D3Js, HighChart,leaflet,

- R : GGplot2, leaflet, Highcharter,SunburstR,

- Python : Pandas, MatPlottlib, Seaborn, Bokeh.

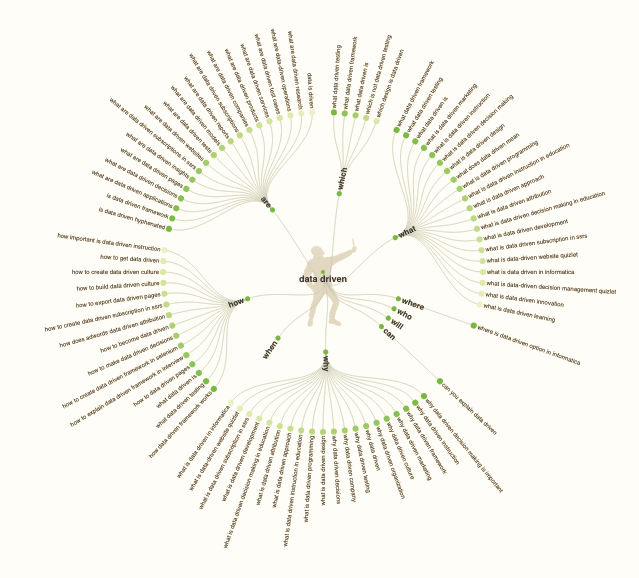

Exemple d’une représentation Radial tidy tree – D3js

Modèle data driven : une évolution nécessaire

L’approche décrite ci-dessus semble aboutie et efficace; toutefois elle n’est viable qu’avec l’obtention massive de données utilisateur. Les différentes lois (Informatique et liberté, RGPD), nous obligent à recueillir explicitement le consentement des utilisateurs avant toute collecte, d’indiquer une durée maximale de conservation et permettre à l’utilisateur de demander la suppression de ses données.

D’autre part

- on assiste également à des réactions collectives : « Les consommateurs agissent de plus en plus en tant que citoyen » – source Opinionway,

- 68 % des français en 2018 considèrent qu’internet met en danger leur vie privée,

- 30 % sont équipés d’un bloqueur de publicité,

- on estime à 15 % les données manquantes au sein d’outils de digital analytics (https://moz.com/blog/analytics-black-holes).

Jusqu’à lors ce modèle orienté data était principalement au service des intérêts des marques (contrôle des dépenses pour la tactique d’acquisition d’audience, parcours d’achat plus efficaces, contenus personnalisés et utilisateurs de fait plus sensibles, compatibilité avec les terminaux accrue).

Bien sûr ces optimisations nourrissent également le confort de l’utilisateur en proposant des parcours fluides et efficaces avec des informations et produits plus en accord avec ses goûts et envies immédiates.

On note d’ailleurs l’apparition de démarches fréquentes reposant sur la capacité de l’utilisateur à définir ses préférences pour son exposition à des publicités. Toutefois comme vu ci-dessus, 30 % ne préfèrent voir aucune publicité allant jusqu’à installer un module complémentaire pour ne plus être exposé.

Dans ce contexte, pourquoi l’utilisateur accepterait-il de continuer à nous confier ses données ?

Data driven : un changement de paradigme nécessaire pour l’équilibre des bénéficiaires

La donnée au service de l’expérience individuelle permettra de :

- Observer et faire attention à l’individu,

- Faciliter l’accès de l’individu à l’information,

- Rendre capacitaire l’individu, lui permettre de développer ses connaissances,

- Valoriser l’individu via un système de gratification.

Certains acteurs ont déjà déployé des plateformes avec des démarches semblables ayant pour objectif la valorisation individuelle. Le service Salesforce Trailhead offre à toute personne de s’auto-former sur la suite logicielle Salesforce. La plateforme propose un sytème de gratification permettant de mesurer sa progression et un profil public afin partager ses résultats et de valoriser ses nouvelles compétences.

La donnée comme levier d’amélioration de la vie en collectivité

- Faire l’inventaire des différences et des intérêts communs,

- Observer les sous-ensembles (distribution),

- Comprendre les distorsions entre les intérêts individuels et les intérêts collectifs,

- Développer le partage, les échanges, la cohésion, le respect des différences, augmenter l’efficacité collective,

- Valoriser les réussites collectives, intégrer de nouveaux individus.

Un projet Kaggle illustre bien l’amélioration des services bénéficiant à la collectivité ; l’amélioration du service Velib . Il s’agit de combiner les tendances historiques d’utilisation avec les données météorologiques afin de prévoir la disponibilité et la demande des Velib (ou tout autre service de même type) en station. Ici, les données de chaque utilisateur permettent d’améliorer un service collectif.

Alors que l’exploitation des données utilisateurs servait strictement la performance commerciale, il parait impératif pour les différentes raisons évoquées dans cet article d’organiser la collecte et l’exploitation des données utilisateurs à son bénéfice qu’il soit individuel ou collectif.

Photo by Nicolai Berntsen on Unsplash